Prompt Injection to jedno z najpoważniejszych zagrożeń, przed którymi stoją dziś systemy oparte na sztucznej inteligencji. Ten typ ataku polega na manipulowaniu danymi wejściowymi w taki sposób, aby skłonić model AI do wygenerowania niepożądanych lub szkodliwych odpowiedzi, co może prowadzić do ujawnienia poufnych informacji, błędnych działań systemu, a nawet naruszeń bezpieczeństwa. Dowiedz się, jak działa Prompt Injection, dlaczego stanowi realne ryzyko dla aplikacji AI i jakie strategie pozwalają skutecznie się przed nim bronić.

Co to jest Prompt Injection?

Prompt injection to wysublimowana forma cyberataku, opierająca się na precyzyjnej manipulacji danymi wejściowymi w potężnych modelach językowych – takich jak chatboty czy systemy AI. Atakujący posługuje się specjalnie spreparowanymi komendami lub sugestiami, mającymi na celu skłonienie systemu do działań, które są dalekie od pożądanych. W rezultacie może to prowadzić do produkcji fałszywych informacji, ujawnienia poufnych danych albo wykonania operacji bez odpowiednich upoważnień.

Jak dochodzi do takiego ataku? Kluczem jest dogłębne zrozumienie działania modeli językowych i ich podatności na specyficzne dane wejściowe. Modele te przetwarzają naturalny język, ale niestety są także podatne na szkodliwe manipulacje, co może prowadzić do nieprzewidywalnych reakcji.

Prompt Injection znajduje zastosowanie zarówno w prostych dialogach pytanie-odpowiedź, jak i w bardziej skomplikowanych scenariuszach wymagających interpretacji przez AI złożonych kontekstów. Twórcy i użytkownicy systemów AI powinni zatem być świadomi tego rodzaju zagrożeń i potrafić chronić swoje technologie przed atakami.

Wraz z postępem w rozwoju modeli językowych w różnych dziedzinach – od obsługi klienta po systemy bezpieczeństwa, technika ta staje się coraz bardziej istotna. Odpowiednia ochrona przed Prompt Injection to nieustanne monitorowanie i aktualizowanie protokołów bezpieczeństwa. Tylko takie podejście pozwoli nam przeciwdziałać nowym technikom ataku oraz zapewnić integralność i zaufanie do systemów opartych na AI.

Rodzaje Prompt Injection

Gdy zagłębiamy się w temat różnorodności ataków typu Prompt Injection, warto mieć na uwadze, że możemy je podzielić na dwa zasadnicze rodzaje. Mowa tu o atakach bezpośrednich i pośrednich, a każdy z nich charakteryzuje się swoimi specyficznymi cechami oraz metodami działania.

Ataki bezpośrednie dotyczy sytuacji, w których nieupoważnione osoby są w stanie wprowadzić szkodliwe instrukcje bezpośrednio do modelu AI. Takie coś ma miejsce na przykład poprzez formularze online, chatboty czy inne punkty skąd dane mogą być przetwarzane przez sztuczną inteligencję. Wystarczy, że użytkownik wpisze odpowiednio spreparowane pytanie w wyszukiwarkę internetową, która korzysta z AI do generowania odpowiedzi. Skutkiem takiego działania może być nieautoryzowany dostęp lub manipulacja systemem.

Z kolei ataki pośrednie są nieco bardziej wyrafinowane. One polegają na umieszczaniu szkodliwych instrukcji w miejscach dostępnych dla modelu AI — na przykład w dokumentach tekstowych czy metadanych zdjęć. W ten sposób napastnicy mogą manipulować danymi tak, aby ich przetworzenie przez AI skutkowało nieprzewidzianymi konsekwencjami, np. poprzez osadzenie specjalnej frazy w dokumencie PDF analizowanym przez system AI.

Obydwa typy ataków to duże wyzwanie dla twórców i użytkowników systemów AI. Wymagają od nich świadomości tych zagrożeń i podejmowania działań mających na celu zabezpieczenie się przed nimi. Zrozumienie mechanizmów działania zarówno bezpośrednich, jak i pośrednich ataków typu Prompt Injection, jest kluczowe dla ochrony naszych systemów informatycznych przed manipulacjami danymi oraz nieautoryzowanym dostępem. Metody te stanowią poważne zagrożenie dla bezpieczeństwa cyfrowego oraz integralności danych przetwarzanych przez modele językowe oparte na sztucznej inteligencji.

Konsekwencje ataków Prompt Injection

Ataki Prompt Injection, mimo że wymagają technicznej precyzji, niosą ze sobą konkretne i często niszczycielskie skutki dla ochrony danych i systemów. Najbardziej poważne konsekwencje to:

- ujawnienie tajnych danych: hakerzy mogą wykorzystać słabości w systemach AI do zdobycia nieuprawnionego dostępu do poufnych informacji, takich jak dane osobowe użytkowników czy tajemnice biznesowe. To może prowadzić do utraty zaufania klientów oraz spowodować znaczne straty finansowe,

- kradzież danych: ta zaawansowana forma ataku obejmuje wykradanie informacji z chronionych sieci przedsiębiorstw. Zazwyczaj wykorzystuje manipulację danymi wejściowymi w celu przemytu zapytań, które inicjują nieautoryzowane przesyłanie danych na serwery osób nieupoważnionych,

- zdalne uruchamianie kodu: w pewnych okolicznościach Prompt Injection może umożliwić wykonanie dowolnego kodu na serwerze ofiary. To stwarza możliwość dalszych manipulacji systemem, instalacji złośliwego oprogramowania lub nawet przejęcia kontroli nad całą infrastrukturą IT,

- zmiana działania aplikacji przez manipulację danymi: ataki te mogą wpływać na funkcjonowanie aplikacji AI poprzez modyfikację lub fałszywe dane wejściowe, co prowadzi do błędnych decyzji biznesowych lub technologicznych,

- krzywdzenie reputacji: informacje o naruszeniu bezpieczeństwa mogą wpłynąć na wizerunek marki w oczach konsumentów i partnerów biznesowych.

Wykorzystanie Prompt Injection w praktyce

Prompt Injection, technika wstrzykiwania poleceń, może przybierać rozmaite oblicza – wszystko zależy od celów i zdolności osoby atakującej. Przełamywanie zabezpieczeń wielkich modeli językowych (LLM) czy penetrowanie korporacyjnych baz danych to jedynie kilka przykładów zaawansowanych użycia tej metody. Ataki te polegają na manipulacji danymi wprowadzanymi do modelu językowego w celu wywołania nieautoryzowanych działań lub dostępu do tajnych informacji.

Jednym ze sposobów jest podsuwanie spreparowanych komend lub sugestii przez interfejs użytkownika – chatboty czy formularze online mogą stanowić tu doskonałe narzędzie. Pozwala to omijać standardowe mechanizmy kontroli i uzyskiwać dostęp do ukrytych funkcji systemu. Można na przykład tak skonfigurować API systemu, aby reagowało na specjalnie spreparowane żądania, które skutkują odsłonięciem poufnych danych.

Innym podejściem jest tworzenie dokumentów lub plików zawierających ukryte polecenia. Kiedy sztuczna inteligencja analizuje tego typu dokumenty — na przykład podczas procesu digitalizacji danych — może nieświadomie uruchomić zaprogramowane przez hakera akcje. Mogą one obejmować zmiany w konfiguracji systemowej lub operacje sieciowe, które prowadzą do dalszych naruszeń bezpieczeństwa.

Zwracając uwagę na ten aspekt bezpieczeństwa cyfrowego, firmy są w stanie skuteczniej chronić swoje zasoby przed zaawansowanymi atakami typu Prompt Injection i utrzymać zaufanie klientów oraz stabilność operacyjną swoich systemów informatycznych.

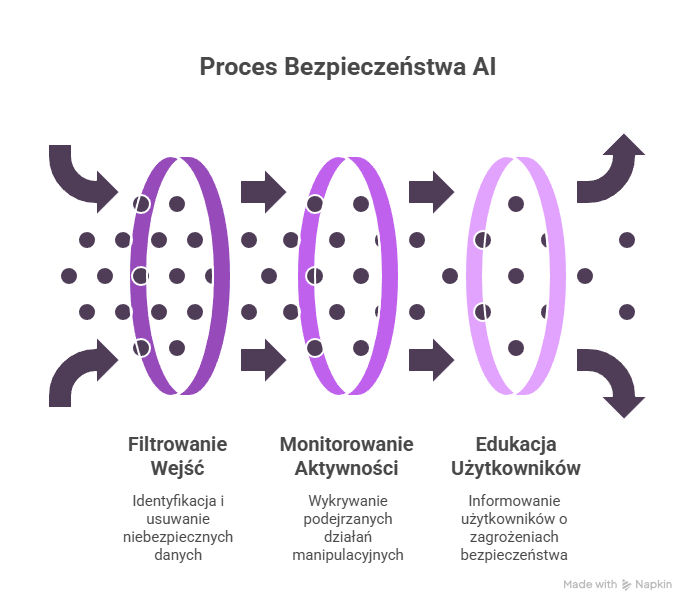

Zapobieganie i ochrona przed Prompt Injection

Należy podejść kompleksowo do tego problemu, skupiając się na kilku kluczowych aspektach:

- walidacja przez ludzi – możemy identyfikować i eliminować szkodliwe polecenia, które są wprowadzane do systemów AI. Nasza obecność pozwala wyłapywać niestandardowe lub podejrzane dane wejściowe – istotne elementy prób manipulacji modelami językowymi,

- weryfikacja i kontrola dostępu – wszystko zależy od odpowiedniej konfiguracji systemów autoryzacji, które powinny ograniczać dostęp do kluczowych części systemu tylko dla zaufanych użytkowników. W ten sposób zdecydowanie zmniejszymy ryzyko nieautoryzowanego użycia danych przez osoby trzecie,

- monitorowanie i analiza interakcji użytkowników z aplikacjami AI – dzięki zaawansowanym narzędziom jesteśmy w stanie wykrywać nietypowe zachowania sugerujące próby ataku typu Prompt Injection. Pamiętajmy o regularnych aktualizacjach tych systemów zgodnie ze standardami bezpieczeństwa,

- edukacja użytkowników końcowych – wiedza na temat mechanizmów bezpieczeństwa oraz możliwych zagrożeń związanych z nieprawidłową interakcją z systemami AI jest niezwykle ważna. Zrozumienie, jak dane wejściowe są przetwarzane przez modele językowe i jak mogą być manipulowane, stanowi podstawowy element ochrony przed cyberatakami,

- segmentacja danych – dzięki niej możemy izolować najważniejsze informacje i ograniczyć dostęp do nich tylko dla upoważnionych osób. To utrudnia potencjalnym hakerom przeprowadzenie skutecznych ataków poprzez ograniczenie skali naruszenia.

Pamiętajmy, że ochrona przed atakami typu Prompt Injection to proces wymagający precyzyjnych działań technicznych oraz strategicznego planowania na różnych poziomach funkcjonowania organizacji. Wdrożenie wysokiego poziomu walidacji decyzji ludzkich, narzędzi monitorujących oraz procedur kontroli dostępu to fundament efektywnej ochrony przed tym rodzajem cyberzagrożeń.

swój potencjał z

polityką prywatności

![Najpopularniejsze platformy e-commerce w Polsce – ranking [TOP 11]](https://semcore.pl/wp-content/uploads/2024/07/q-36-150x150.jpg)