AI Act to przełomowe rozporządzenie Unii Europejskiej, które wprowadza jednolite zasady dotyczące rozwoju, wdrażania i wykorzystania systemów sztucznej inteligencji w krajach członkowskich. Celem aktu jest zwiększenie bezpieczeństwa, przejrzystości oraz ochrony praw użytkowników, a jednocześnie stworzenie sprzyjających warunków dla innowacji i konkurencyjności europejskiego rynku technologicznego. Dowiedz się, kiedy przepisy wejdą w życie, kogo dokładnie obejmą i jakie zmiany przyniosą dla firm, instytucji i użytkowników końcowych.

Czym jest AI Act?

Akt o Sztucznej Inteligencji, znany również jako AI Act, to kluczowy dokument regulacyjny wydany przez Unię Europejską, który zyskał swoją formę ostateczną 12 lipca 2024 roku. Głównym zadaniem tego aktu jest kontrola i nadzór nad sposobem, w jaki technologia AI jest używana przez firmy i instytucje publiczne, a także zapewnienie bezpieczeństwa i ochrony danych osobowych w kontekście systemów AI

Celem AI Act jest nie tylko zwiększenie bezpieczeństwa i transparentności AI, ale również stworzenie sprzyjającego środowiska dla innowacji i konkurencyjności europejskiego sektora cyfrowego. AI Act ma zwiększyć przejrzystość funkcjonowania systemów opartych na sztucznej inteligencji. Co powinno skutkować wzrostem zaufania społecznego do tej technologii oraz jej akceptacji.

Dokument wprowadza również mechanizmy mające na celu zapobieganie wykorzystywaniu AI w sposób naruszający prawa człowieka – zakazuje praktyk ryzykownych lub szkodliwych, takich jak manipulowanie zachowaniami ludzi w sposób niezauważalny dla nich samych.

AI Act nakłada konkretne obowiązki na dostawców systemów opartych na sztucznej inteligencji. Zanim ich produkty trafią na rynek, muszą oni przeprowadzić dogłębne testy bezpieczeństwa i oceny wpływu tych produktów na prawa podstawowe użytkowników. Dzięki temu każdy – zarówno przedsiębiorstwa, jak i osoby prywatne – mogą czuć się lepiej chronieni przed ewentualnymi negatywnymi skutkami działania AI.

Kategorie ryzyka w AI Act

Podstawą Aktu AI jest klasyfikacja ryzyka związanego z wykorzystaniem sztucznej inteligencji. Ta klasyfikacja jest kluczowa, ponieważ pozwala na dostosowanie przepisów do potencjalnego wpływu różnych aplikacji AI na społeczeństwo oraz jednostki. Możemy wyróżnić cztery główne kategorie ryzyka:

- niskie ryzyko — stanowią je systemy AI, które uważa się za bezpieczne i które nie mają wielkiego, negatywnego wpływu na prawa i wolności ludzkie. Typowym przykładem mogą być chatboty obsługujące klientów w standardowych pytaniach. Wymagania dla tych systemów są podstawowe i obejmują głównie transparentność,

- średnie ryzyko — to kategoria dla systemów, które mogą mieć większe znaczenie dla naszego codziennego życia. Przykładowo, aplikacje sugerujące produkty finansowe czy edukacyjne – tutaj błędne rekomendacje mogą prowadzić do niewłaściwych decyzji,

- wysokie ryzyko — tu mamy do czynienia z systemami AI, które mają bezpośredni wpływ na zdrowie, bezpieczeństwo lub podstawowe prawa obywateli. Możemy tu wymienić diagnozę medyczną czy narzędzia rekrutacyjne decydujące o karierze zawodowej. Dla tej grupy wymagania są znacznie bardziej surowe i obejmują wiele testów bezpieczeństwa i etycznych,

- niedopuszczalne ryzyko — to najbardziej restrykcyjna kategoria, dotycząca użycia AI, które jest uznane za nieakceptowalne ze względu na negatywny wpływ na podstawowe prawa i godność człowieka. Zabrania się tutaj używania technologii, które manipulują zachowaniami ludzi w sposób niezauważalny lub umożliwiają masową inwigilację.

Podział ten jest kluczowy dla znalezienia równowagi między innowacyjnością a ochroną praw obywateli w erze cyfrowej. Każda z kategorii wiąże się z określonymi przepisami wykonawczymi i procedurami oceny zgodności, co tworzy odpowiednie ramy prawne dla rozwiązań opartych na sztucznej inteligencji.

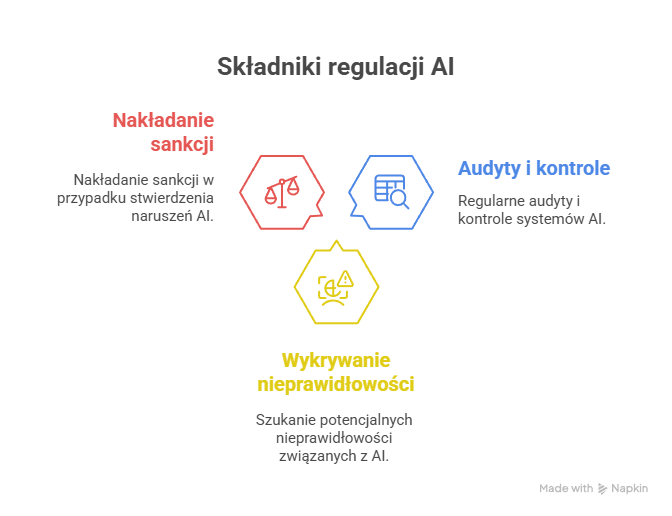

Wdrożenie i egzekwowanie AI Act

Kluczową rolę w skutecznym wprowadzaniu i egzekwowaniu przepisów AI Act odgrywają nie tylko europejskie organy regulacyjne, ale także dostawcy i operatorzy systemów AI. To oni razem muszą tworzyć fundamenty, na których będzie opierała się cała machina sztucznej inteligencji. Regulacje przewidują, że nadzór nad tym procesem przejmą agencje rządowe oraz niezależne instytucje. Ich zadaniem będzie obserwowanie, jak firmy radzą sobie z implementacją standardów bezpieczeństwa i etyki. To one będą miały oko na produkty oparte na AI – zarówno przed ich wprowadzeniem na rynek, jak i podczas użytkowania.

Ale sama kontrola to nie wszystko. Równie istotna jest edukacja społeczeństwa oraz budowanie świadomości dotyczącej nowych regulacji. Organizacje konsumenckie oraz grupy obrońców praw człowieka powinny aktywnie monitorować skutki stosowania AI – takie podejście zdecydowanie podnosi przejrzystość całego procesu.

Kiedy AI Act wejdzie w życie?

Nowe regulacje dotyczące sztucznej inteligencji, już obowiązują od 1 sierpnia 2024 roku. To przełomowy moment dla wszystkich przedsiębiorców i operatorów systemów AI, którzy muszą odpowiednio przygotować się na tę ewolucję.

Wprowadzanie tych przepisów będzie realizowane etapami, co znacznie ułatwi proces dostosowania do nowych wymogów. W zależności od specyfiki oraz skali wykorzystania sztucznej inteligencji w biznesie, różne sektory technologiczne będą miały od półtora roku do trzech lat na wdrożenie niezbędnych zmian. Wszystko to będzie także uzależnione od poziomu ryzyka związanego z konkretnym rozwiązaniem AI.

Od 2026 przepisy mają być już egzekwowane w pełni. Oznacza to jasny sygnał dla wszystkich — wszelkie nieprawidłowości mogą skutkować surowymi konsekwencjami, w tym karami finansowymi. Takie podejście ma za zadanie zagwarantować wysoki poziom bezpieczeństwa i etyczności systemów AI we wszystkich krajach Unii Europejskiej.

Wpływ AI Act na innowacje i cyfrowy sektor

Zmiana zgodnie z nowymi regulacjami może być wyzwaniem, ale z czasem powinna przyczynić się do wzrostu zaufania konsumentów do technologii AI. Z pewnością większa przejrzystość i bezpieczeństwo w korzystaniu z AI będą miały pozytywny wpływ na społeczne postrzeganie tych technologii. Możliwe, że przyspieszy to także wdrażanie innowacyjnych rozwiązań w różnych dziedzinach – od biznesu, przez administrację, aż po służbę zdrowia.

Ważnym aspektem jest również konkurencyjność europejskiego sektora cyfrowego. Dzięki jednolitym standardom będzie mógł on skuteczniej konkurować na globalnym rynku z gigantami technologicznymi z USA czy Chin, gdzie regulacje są mniej restrykcyjne.

Pomimo tego, że AI Act wprowadza pewne ograniczenia dla producentów systemów opartych na sztucznej inteligencji, otwiera też nowe możliwości. Rozwój etycznych algorytmów czy systemy oceny zgodności mogą stać się nowymi obszarami innowacji. Wpływ AI Act na innowacje i sektor cyfrowy jest nie do przecenienia. Mimo że wiąże się z wyzwaniami dla firm technologicznych, to jednocześnie stwarza szanse na rozwój bezpiecznych i społecznie akceptowanych technologii sztucznej inteligencji.

swój potencjał z

polityką prywatności

![Najpopularniejsze platformy e-commerce w Polsce – ranking [TOP 11]](https://semcore.pl/wp-content/uploads/2024/07/q-36-150x150.jpg)