Nadchodzi nowa era indeksowania stron! Google wprowadza robota AI, który zmieni sposób, w jaki witryny są indeksowane na życzenie właścicieli. To jednak nie koniec nowości. Martin Splitt z Google ostrożnie podchodzi do automatycznych audytów SEO, podważając ich rzeczywistą wartość. Tymczasem spamerzy z Reddita znajdują nowe sposoby na wykorzystanie luk w systemie, manipulując wynikami wyszukiwania w Google.

Oprócz tego: Google rozwiewa wszelkie wątpliwości dotyczące wpływu ruchu na pozycjonowanie, jednoznacznie stwierdzając, że ruch w witrynie nie wpływa na wyniki w SERP-ach.

Najświeższe informacje o SEO od Semcore… czas start!

Źródło: https://img.freepik.com/free-photo/people-working-elegant-cozy-office-space_23-2149548797.jpg?t=st=1724756881~exp=1724760481~hmac=01ac91680a7d1e0f53e757a47745dfa39b20ae044b00ced3dba41fb6b11f7f4d&w=900

Google uruchamia nowego robota indeksującego AI wspierającego SEO!

Google wprowadził nowego robota indeksującego AI o nazwie Google-CloudVertexBot, który działa na zlecenie właścicieli witryn. Ten nowy bot, będący częścią usługi Vertex AI, pozwala na bardziej zaawansowane indeksowanie stron internetowych (a w tym sprawniejsze pozycjonowanie). W odróżnieniu od standardowych robotów Google, które skanują publiczne strony internetowe, działa wyłącznie na życzenie właścicieli witryn – nie będzie automatycznie indeksował treści publicznych.

Zdj 1. Nowy robot indeksujący AI od Google.

Źródło: developers.google.com/search/updates?hl=pl#introducing-the-google-cloudvertexbot-crawler

Dokumentacja Google wskazuje, że Google-CloudVertexBot jest odpowiedzialny za indeksowanie danych wykorzystywanych przez klientów Vertex AI. Obejmuje to zarówno podstawowe, jak i zaawansowane indeksowanie stron, przy czym to drugie wymaga weryfikacji domeny przez właściciela witryny oraz spełnienia określonych limitów indeksowania.

„Warto zwrócić uwagę na fakt, że nowy robot nie jest przeznaczony do masowego indeksowania publicznych stron internetowych, a jego działanie ogranicza się do witryn, które wyraziły zgodę na jego użycie”. – Marcin Stypuła, CEO Semcore.

Popularne porady dotyczące audytów SEO – Czego Google odradza?

Martin Splitt z Google zwrócił uwagę na ograniczoną przydatność niektórych sugestii dostarczanych przez narzędzia do audytów SEO. Podkreślił, że wiele z tych rekomendacji nie ma rzeczywistego wpływu na wyniki wyszukiwania. W swojej wypowiedzi podczas Google SEO Office Hours Splitt wyraził sceptycyzm szczególnie wobec stosunku tekstu do kodu, który według niego nie jest istotny dla Google.

Zdj 2. Istotne kwestie poruszone przez Google w temacie audytów SEO.

Źródło: www.youtube.com/watch?v=Fj42gKDQxYI

Splitt zauważył, że wiele audytów SEO skupia się na technicznych aspektach, które nie mają bezpośredniego związku z pozycjonowaniem. Przykładowo, minifikacja CSS i JavaScript, choć jest dobrym zwyczajem, nie wpływa bezpośrednio na pozycje w wynikach wyszukiwania.

Zapamiętaj!

Zamiast polegać wyłącznie na narzędziach audytowych, warto konfrontować ich rekomendacje z oficjalną dokumentacją Google, która, mimo swoich ograniczeń, jest najlepszym źródłem wiedzy na temat optymalizacji stron internetowych.

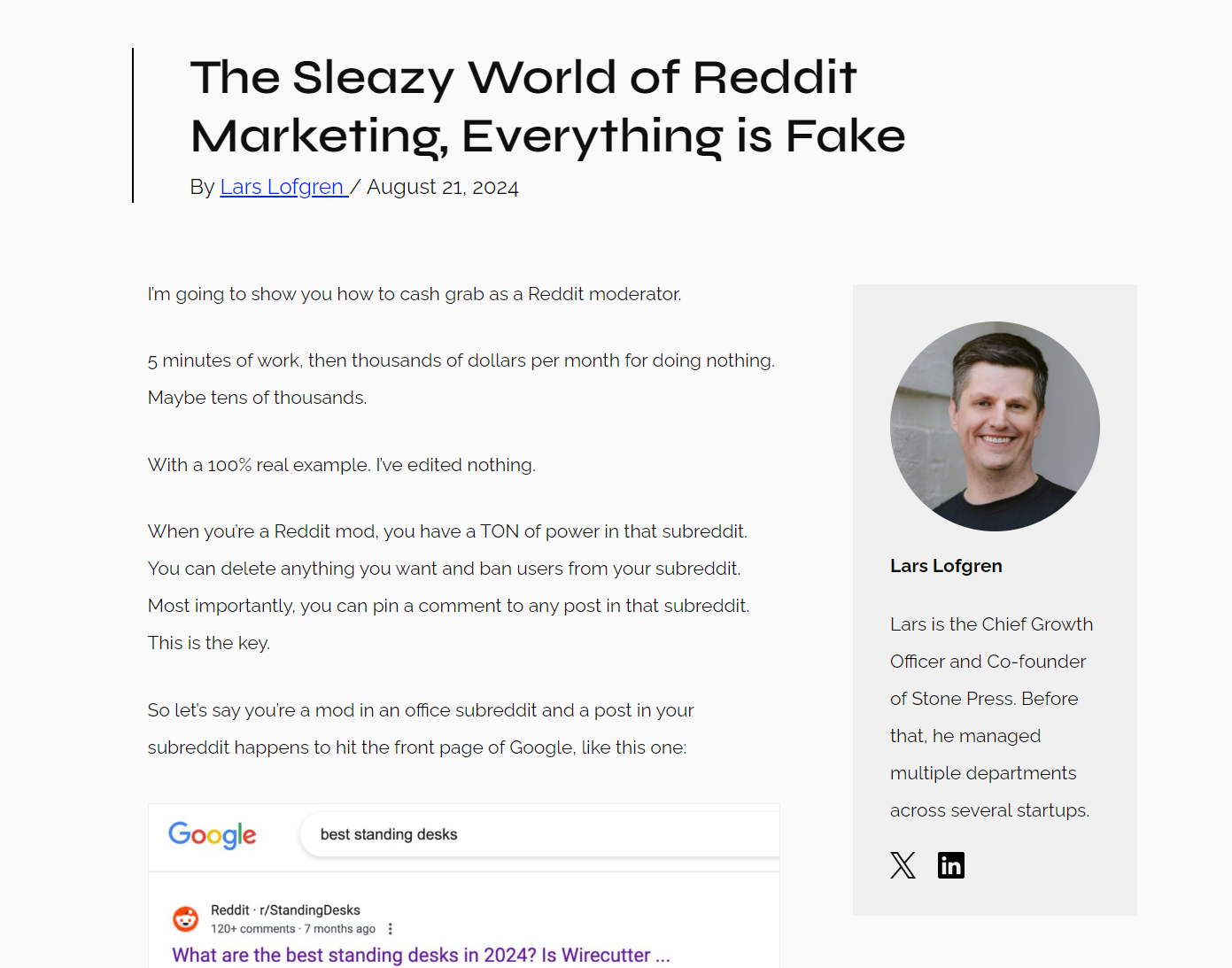

W jaki sposób spamerzy pozycjonują się w Google z pomocą Reddita?

Lars Lofgren, ekspert w dziedzinie SEO, ujawnił, w jaki sposób spamerzy wykorzystują preferencje Google do promowania treści z Reddita w wynikach wyszukiwania. Reddit, będący platformą z ogromną liczbą anonimowych i często słabo moderowanych dyskusji, stał się łatwym celem dla tych, którzy chcą wykorzystać jego popularność.

Zdj 3. Bardzo ciekawy artykuł na temat fake marketingu w Google poprzez Reddita.

Źródło: www.larslofgren.com/REDDIT-MARKETING/

Lofgren zidentyfikował sześć technik, które spamerzy stosują na Reddicie, aby promować strony afiliacyjne. Jedną z nich jest zdobywanie kontroli nad tzw. subredditem – umożliwia to przypinanie swoich komentarzy na górze dyskusji, zwiększając widoczność ich linków w Google.

Kolejną metodą jest wykorzystywanie „sock puppetów” – fałszywych kont, które tworzą iluzję autentycznego dialogu, by przemycić spamerskie linki do popularnych dyskusji. Wszystkie te działania powodują, że Google musi intensywniej monitorować treści z Reddita, w celu wyeliminowania spamu.

Ruch w witrynie nie ma wpływu na wyniki w SERP-ach! Oficjalne stanowisko Google.

Martin Splitt z Google wyjaśnił, że ruch na stronie internetowej nie wpływa na jej pozycje w wynikach wyszukiwania. W odpowiedzi na pytanie dotyczące wiarygodności stron i możliwości manipulacji wynikami przez konkurencję, Splitt podkreślił, że Google nie ocenia zaufania do witryny na podstawie ruchu generowanego przez boty czy linki zewnętrzne.

Splitt zaznaczył, że w ocenie wiarygodności stron Google kieruje się sygnałami, które są złożone i wielowymiarowe, ale żaden z nich nie jest bezpośrednio związany z ruchem na stronie. W przypadku fałszywego ruchu generowanego przez boty Google jest w stanie odróżnić go od prawdziwych użytkowników.

Zdj 4. Informacje na temat ruchu w witrynie a wynikach w SERPach.

Źródło: www.youtube.com/watch?v=Fj42gKDQxYI

swój potencjał z

polityką prywatności

![Najpopularniejsze platformy e-commerce w Polsce – ranking [TOP 11]](https://semcore.pl/wp-content/uploads/2024/07/q-36-150x150.jpg)