Jako osoba prowadząca witrynę, możesz wskazywać Google, które materiały nie powinny trafić do indeksu wyszukiwarki. Żeby to zrobić, możesz skorzystać z X-Robots-Tag za pomocą którego pokierujesz botami. Sprawdź, co to jest i jak z tego skorzystać.

Co to jest X-Robots-Tag?

To dyrektywa w nagłówkach HTTP, za pomocą której dostarczasz wyszukiwarkom instrukcje dotyczące indeksowania i wyświetlania w SERP-ach (Search Engine Results Page) poszczególnych stron. Być może lepiej znasz inną metodę – dodawanie odpowiedniego tagu w meta robots. Obie są tak samo skuteczne, ale różnią się sposobami przekazywania parametrów robotom indeksującym.

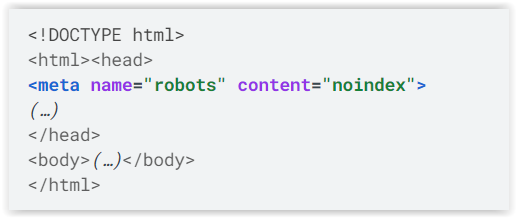

Tag meta robots umieszcza się w sekcji <head> strony. Może wyglądać np. jak na poniższej grafice. Taka jego treść oznacza, że Google ma nie indeksować strony, na której umieszczono ten kod.

Źródło: https://developers.google.com/search/docs/crawling-indexing/robots-meta-tag?hl=pl

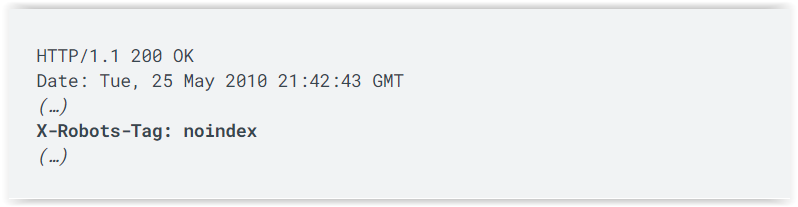

Natomiast X-Robots-Tag jest alternatywą dla meta robots. W tym przypadku kod wygląda następująco:

Źródło: https://developers.google.com/search/docs/crawling-indexing/robots-meta-tag?hl=pl

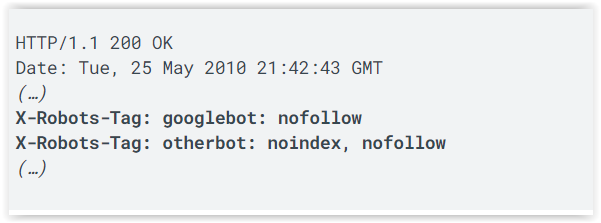

Użycie tego kodu przynosi taki sam efekt. Co więcej, możesz określić wytyczne tylko dla poszczególnych robotów wyszukiwarek, jak w poniższym przykładzie.

Źródło: https://developers.google.com/search/docs/crawling-indexing/robots-meta-tag?hl=pl

Kluczowa różnica między zastosowaniem obu rozwiązań polega na tym, że meta robots jest elementem strony, a X-Robots-Tag jest przekazywane jako część nagłówka HTTP.

Dlaczego warto korzystać z X-Robots-Tag?

Dzięki temu, na jakiej zasadzie używa się X-Robots-Tag, możesz z niego skorzystać w stosunku dowolnej zawartości dostarczanej przez serwer, a nie jedynie stron HTML, jak to wygląda w przypadku meta robots. Meta robots nie ma zastosowania dla plików graficznych czy PDF, a dzięki X-Robots-Tag możesz określić robotom zasady indeksowania i przeglądania takich materiałów przez bota wyszukiwarki.

Jak zaimplementować X-Robots-Tag?

Dodanie kodu w meta robots jest łatwiejsze. Skorzystanie z X-Robots-Tag może sprawić więcej trudności, ale nie jest to czynność, której nie wykonasz bez pomocy specjalisty. Przede wszystkim musisz wiedzieć, na jakiego rodzaju serwerze działa Twoja witryna. Największy udział w rynku mają Apache i Nginx. Jak zaimplementować X-Robots-Tag na tych serwerach?

X-Robots-Tag na serwerach Apache

W tym przypadku musisz edytować plik .htaccess. Znajdziesz go w katalogu głównym witryny. Wystarczy, że dodasz w nim odpowiedni kod. Możesz edytować ten plik po jego pobraniu na dysk urządzenia albo bezpośrednio na serwerze, korzystając z menedżera plików. Funkcję o takiej nazwie z pewnością znajdziesz w panelu zarządzania serwerem np. Direct Admin, cPanel czy autorskich rozwiązaniach. Po dodaniu odpowiedniego kodu, zapisz zmiany w pliku i gotowe.

Najwięcej trudności może przysporzyć przygotowanie odpowiedniego kodu. Oto przykład kombinacji dyrektyw, które poinstruują Googlebota, aby nie indeksował adresów URL z rozszerzeniem „.pdf” ani nie podążał za żadnymi linkami w nich:

<Files ~ „\.pdf$”>

Header set X-Robots-Tag „noindex, nofollow”

</Files>

Jeśli chcesz zablokować indeksowanie wybranych rozszerzeń plików graficznych (PNG, JPG, gif), użyj następującego:

<Files ~ „\.(png|jpe?g|gif)$”>

Header set X-Robots-Tag „noindex”

</Files>

Jeśli samodzielnie przygotowujesz kod, najlepiej przed jego umieszczeniem skonsultuj się ze specjalistą.

X-Robots-Tag na serwerach Nginx

W przypadku maszyn z tym oprogramowaniem edycji wymaga inny plik, w którym musisz umieścić inny kod – chodzi o .conf witryny.

Kod przekazujący te same parametry (blokada indeksowania PDF-ów), co poprzedni, w tym przypadku wygląda następująco:

location ~* \.pdf$ {

add_header X-Robots-Tag „noindex, nofollow”;

}

A oto kod, którym możesz zablokować indeksowanie plików graficznych:

location ~* \.(png|jpe?g|gif)$ {

add_header X-Robots-Tag „noindex”;

}

Pamiętaj, że nie wszystkie wyszukiwarki obsługują meta tags, w niektórych w grę wchodzi wyłącznie X-Robots-Tag. Natomiast w przypadku Google działają oba rozwiązania.

swój potencjał z

polityką prywatności

![Najpopularniejsze platformy e-commerce w Polsce – ranking [TOP 11]](https://semcore.pl/wp-content/uploads/2024/07/q-36-150x150.jpg)